【ナゾロジー】

2023.08.26

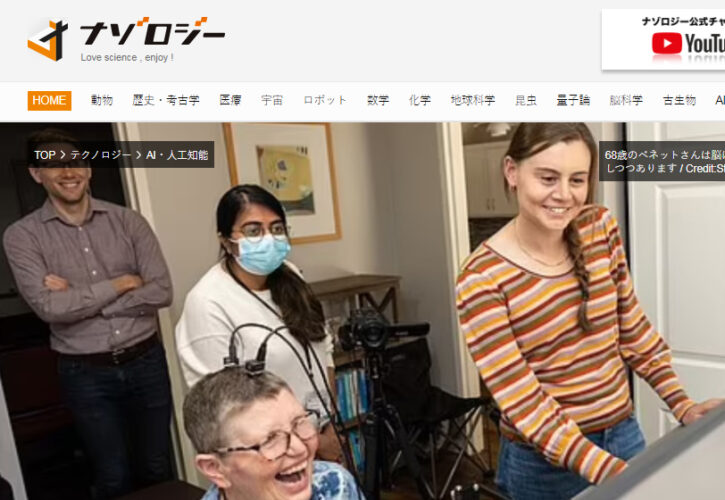

かつてスティーブン・ホーキング博士を苦しめた病気でもある、筋萎縮性側索硬化症(ALS)で発声ができなくなった女性の言葉を、AIが脳活動のパターンから読み取り会話ができるようになりました。

今回の報告は、スタンフォード大学医学部が行った臨床試験の一環で、脳に埋め込まれた4つのセンサーが、1分あたり62ワードという驚きの速さで脳を読み取り、内容をモニターに表示することができたのです。

この驚きの技術は一体どのように確立されたのでしょうか。

この研究内容の詳細は2023年8月23日に『nature』にて公開されています。

目次

発音できない発話の構成要素

現在68歳のパット・ベネットさんは、かつて企業で人事部長としてバリバリ働き、ジョギングや馬術が趣味の活動的な女性でした。

しかし2012年、彼女は筋萎縮性側索硬化症(ALS)と診断されました。

この病気は、運動神経細胞が変性・死滅する神経変性疾患です。これにより筋力が低下し、手足の筋力低下、発話や嚥下(飲み込むこと)の困難、そして呼吸困難などの症状が現れます。

原因は明らかでなく、現在のところ根本的な治療法はありません。

通常、ALSは脊髄から発症するため、腕や脚、手や指といった体の末梢から症状が現れます。しかし、ベネットさんの場合は、症状が脳幹から始まったため、自分で服を着たりする動作はできても、唇、舌、喉頭、顎の筋肉を使うことができなくなり、発話の構成要素である音素(”sh”などの音の単位)をはっきりと発音することができなくなってしまいました。

次ページ39の音素

<

1

2

3

4

>