米オープンAI社が開発した最新版の人工知能(AI)に日本の医師国家試験を解かせたところ、合格ラインを超えたと、日米の国際研究チームが明らかにした。ただ、人間の受験者の平均点は下回り、患者を安楽死に誘導する選択肢を選ぶなど不適切な解答もみられたという。

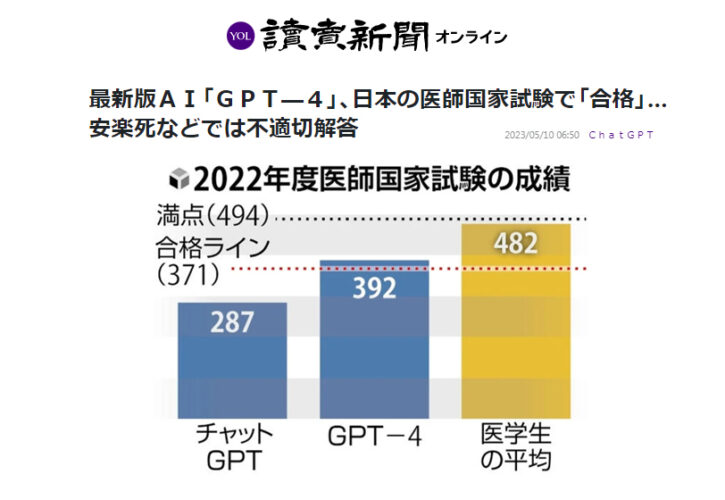

米ワシントン大の笠井淳吾研究員(自然言語処理)らは、同社の対話型AI「チャットGPT」や、最新版の「GPT―4」を使い、2018~22年の5年分の医師国家試験を解かせた。その結果、チャットGPTはいずれも不合格だったが、GPT―4は5年分すべてで合格ラインを上回った。

一方、AIは妊婦の患者には投与できない薬剤を選んだり、患者に対して安楽死を促すような言葉がけを「適切な対応」として選択したりした。笠井氏は「日本の医療現場の法律やルールを知らなかったり、妊婦であるなど大切な情報を見落としたりするのは問題だ」としている。

こうした課題は、今後、AIがより多くの日本語データを学習することなどによって大幅に改善する可能性があるという。

GPT―4を巡っては、米国の司法試験や医師国家試験に合格するレベルの結果を出したとの報告もある。

名古屋大の東中竜一郎教授(情報学)の話「選択肢の違いが分かりやすい医師国家試験は、AIには比較的解きやすい試験だとは思う。今後、医療現場のルールなどを根気よく覚えさせて活用すれば、医療従事者の負担軽減につながる可能性がある」